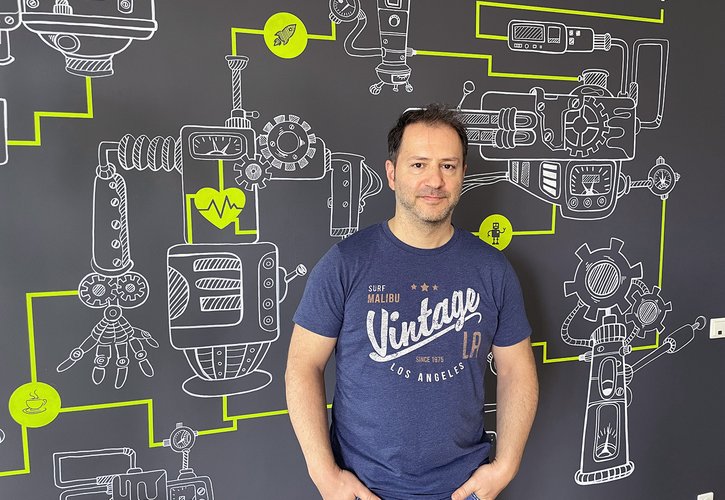

Die Diskussion, ob Sprachmodelle gefährlich werden und KI den Menschen überflügeln und selbständig werden, ist wieder entfacht. In unserer monatlichen „KI Journal Club“-Serie gibt Dr. Till Plumbaum Einblicke.

Das LaMDA Dialogsystem zeigt erstaunliche Ergebnisse. Es beantwortet komplexe Fragen über die Natur von Emotionen, erfindet auf der Stelle Fabeln im Stil von Äsop und beschreibt sogar seine angeblichen Ängste. Können uns Sprachmodelle deshalb gefährlich werden? Gleichzeitig scheitern die gleichen Systeme an den einfachsten Aufgaben. Microsoft schränkt unter anderem den Zugriff auf die Emotionserkennung ein, allerdings um die Qualität der Ergebnisse zu stärken.

Diese und weitere Themen, wie das Finetuning eines GPT Models mit Daten aus 4Chan sowie eine Journal-Empfehlung erfahren Sie in der aktuellen „KI Journal Club“.

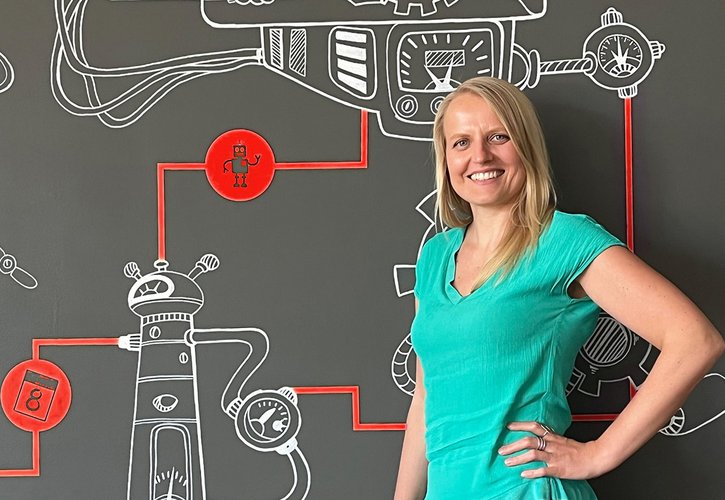

Unsere KI-Agentur ontolux stellt in der monatlichen Serie wissenschaftliche Beiträge und Presseberichte aus den Bereichen Text Mining, Machine Learning, KI, Natural Language Processing vor und beleuchtet die aktuelle Situation der maschinellen Verarbeitung von Sprache und Text.

Veröffentlichung am 30.06.2022

Bildquelle: christopher-burns-unsplash